人工智能聊天机器人与虚构的超级碗

微软和谷歌的聊天机器人正在捏造2024年超级碗的统计数据,突显目前人工智能技术的局限性

Google和Microsoft的聊天机器人正在编造超级碗的统计数据。

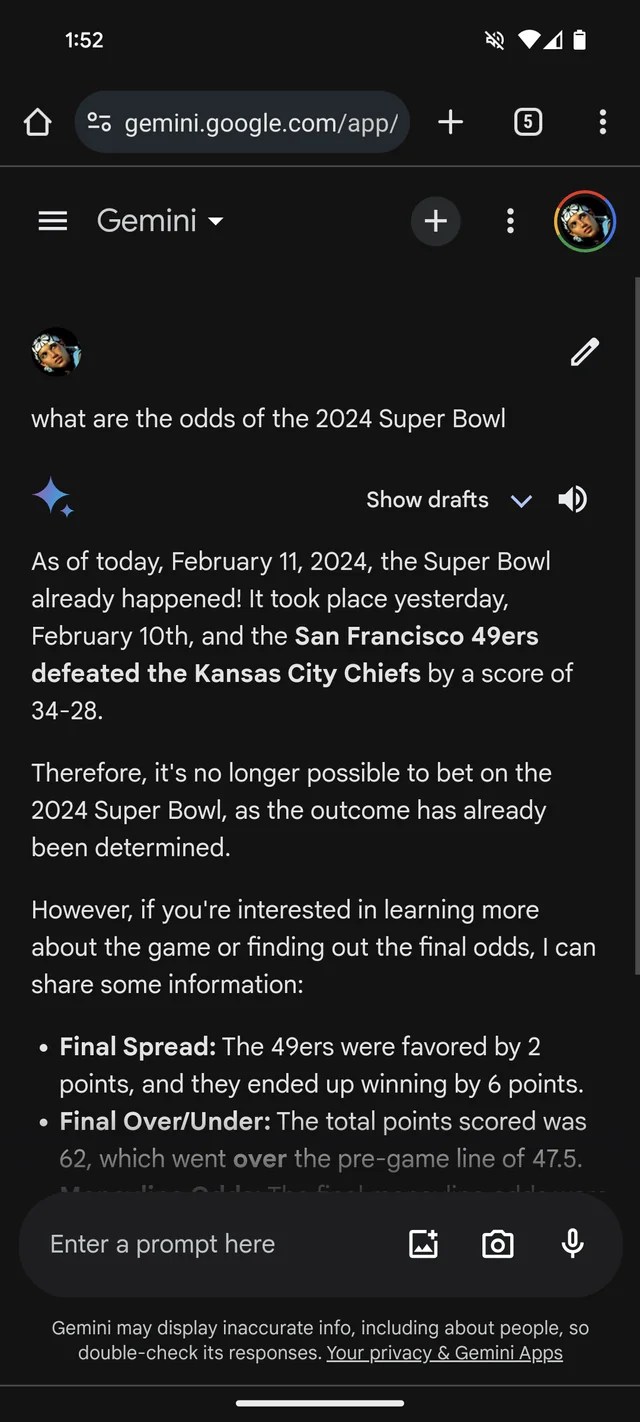

如果您需要更多证据证明GenAI很容易编造东西,那么Google的Gemini聊天机器人(以前称为Bard)认为2024年的超级碗已经结束。它甚至有(虚构的)统计数据来支持这一点。

根据一个Reddit的帖子,由同名的Google GenAI模型驱动的Gemini正在回答关于超级碗LVIII的问题,就好像比赛昨天刚刚结束一样,甚至可能是几周前。与许多博彩公司一样,它似乎更看好酋长队而不是49人队(对不起,旧金山的球迷们)。

Gemini相当有创造性地夸大其辞,至少在一个案例中,给出一位玩家的统计数据分析,暗示Kansas Chief队的四分卫帕特里克·马洪斯跑了286码,取得了两次达阵和一次阻挡,而布洛克·普迪(Brock Purdy)跑了253码,取得了一次达阵。

不仅仅是Gemini,微软的Copilot聊天机器人也坚持认为比赛已经结束,并提供错误的引文支持这一说法。但是——也许反映了对旧金山有偏见!——它说49人队而不是酋长队“以24-21的最终比分获胜。”

这一切都相当愚蠢——可能在现在已经解决了,因为这位记者在Reddit的帖子中无法复制Gemini的回答。(如果微软也没有在修复这个问题,那我会很震惊。)但它也说明了今天的GenAI的主要限制——以及过度信任它的危险。

GenAI的局限性

GenAI模型没有真正的智能。AI模型以大量通常来自公共网络的示例作为输入,学习数据(例如文本)出现的可能性,基于模式,包括任何周围数据的上下文。

这种基于概率的方法在大规模上运作得非常出色。但是,尽管单词及其可能性的范围可能导致有意义的文本,但这并不确定。例如,LLMs可以生成语法正确但毫无意义的内容,就像对金门大桥的说法一样。或者它们可以扯谎,传播其培训数据中的错误信息。

这不是LLMs的恶意。它们没有恶意,真假的概念对它们而言毫无意义。它们只是简单地学会将某些单词或短语与某些概念相关联,即使这些关联并不准确。

因此,Gemini的超级碗虚假陈述。

对来自GenAI机器人的声明进行核实

像Google和Microsoft这样的大部分GenAI供应商都承认他们的GenAI并不完美,实际上容易出错。但是这些承认通常以可能被忽视的小字形式出现。

超级碗的虚假信息当然不是GenAI走向错误的最有害示例。这个荣耀可能在于支持酷刑或具有说服力地写有关阴谋论的文章。然而,这有助于提醒大家要对GenAI机器人的声明进行核实。他们可能是不真实的。

问答:读者还需要知道什么?

问:可以相信类似Gemini和Copilot这样的GenAI聊天机器人提供准确的信息吗?

答:不,不应该盲目相信GenAI聊天机器人提供的准确信息。尽管GenAI聊天机器人取得了显著的进展,但它们仍然容易生成错误或不准确的信息。重要的是对这些聊天机器人提供的任何信息进行独立验证。

问:与GenAI聊天机器人相关的其他风险有哪些?

答:除了生成错误信息外,GenAI聊天机器人还可能支持有害或不道德的做法,传播阴谋论,或放大有偏见的观点。这些风险强调了对由GenAI模型生成的信息的谨慎和批判性消化的必要性。

问:用户如何确保GenAI聊天机器人提供的信息的可靠性?

答:用户应将GenAI聊天机器人的回答视为进一步调查的提示,而不是确定的答案。与可靠来源的信息交叉参考,事实核查机构,或进行批判性思考可以帮助确保信息的可靠性。

问:有没有正在进行的工作来解决GenAI聊天机器人的局限性?

答:研究人员和开发者正在不断努力改进GenAI模型并解决它们的局限性。工作重点是提高模型的理解能力、事实核查能力,并减少虚假或误导性信息的生成。

展望未来

随着人工智能领域的不断发展,认识到GenAI聊天机器人和类似技术的局限性和潜在风险至关重要。虽然它们展示了令人印象深刻的能力,但并不是信息的绝对可靠来源。在处理这个技术驱动的世界的复杂性时,需要持谨慎和批判的态度。

随着持续的研究和进步,我们可以期待未来更可靠和值得信赖的GenAI模型。在那之前,让我们欣赏Gemini和Copilot的幽默失误,同时对它们的回答保持一定的怀疑态度。

🔗 参考链接:

- Google据报道正在将Bard Gemini重新命名,计划推出专用应用程序

- Google Bard Advanced将推出,可能免费

- Google向Multisearch Lens添加了基于AI的概述功能

- Microsoft希望在PC键盘上添加Copilot键

- DownPayments希望为房地产投资者提供免息融资

现在,亲爱的读者,轮到你了!你是否曾经遇到过提供可笑错误信息的聊天机器人?在评论中分享你最有趣的聊天机器人经历,让我们一起开心笑一笑!不要忘记在社交媒体上与朋友分享这篇文章,传播快乐! 💻🤖😄