“生成式人工智能能够解决计算机科学中最大的未解决问题吗?”

生成式人工智能解决未解决问题吗?

当计算机科学家聚会时,他们往往会聊一些关于计算机科学中最重要的未解决问题:P = NP问题。

这个问题在近50年前提出,是关于计算机能够达到什么样的最终成就的深入思考。尽管经过几十年的深入研究,这个问题对于密码学和量子计算等领域具有重要意义,但它仍然没有一个令人信服的答案。现在,这个问题的研究已经得到了生成式人工智能的帮助。

此外:DeepMind的RT-2使机器人控制成为人工智能对话的问题

在一篇名为“Large Language Model for Science: A Study on P vs. NP”的论文中,主要作者董庆秀和同事们使用OpenAI的GPT-4大型语言模型,采用了他们称之为“苏格拉底方法”的几轮与GPT-4的对话。 (这篇论文是由微软、北京大学、北京航空航天大学和北京工商大学的科学家于本月在arXiv预印本服务器上发布的。)

团队的方法相当于从先前的论文中提取论点,并将它们输入GPT-4以引发有用的回答。

- 立即升级到Windows 11 Pro和Microsoft Office Pro,仅需50美元

- 最佳OLED显示器优惠:仅从370美元起获得一台OLED屏幕| ENBLE

- Bing Chat的广告正在将用户发送到危险的恶意软件网站 | ENBLE

董庆秀和团队观察到GPT-4证明了P实际上不等于NP的论点。他们声称这项工作表明大型语言模型不仅能够返回大量的文本,还可以“发现新的见解”,可能导致“科学发现”,他们称之为“LLMs for Science”的前景。

要理解作者们的做法,有必要了解一些关于P = NP问题的知识。

由计算机科学家Stephen Cook和Leonid Levin在20世纪70年代独立提出的P与NP问题,或者简称为“P = NP”,是关于用计算机解决给定问题的难易程度的问题。字母P表示已经被证明可行的问题,也就是说,计算解的时间不会超出范围;而且解决方案也很容易验证,也就是说,检查答案是否正确。

此外:微软和TikTok给予生成式人工智能一种记忆

相比之下,字母NP代表的是问题的答案相对容易验证,就像P一样,但目前没有已知的简单方法来计算解决方案。通常以数独游戏作为NP的例子:任何填满的数独游戏都可以很容易地检查正确性,但是随着游戏格子的增多,寻找解决方案所需的时间成指数增长。(如果您想深入了解P = NP的理论细节,请查阅Cook在2000年写的关于这个问题的论文。)

因此,P = NP问题的关键是询问我们认为难以解决的问题,NP,但我们知道很容易验证,实际上可能会变得既容易验证又容易解决,就像P问题一样。

否定的答案,即P不等于NP,意味着某些问题超出了计算机的能力,即使拥有巨大的计算预算也无法解决-换句话说,计算的上限。因此,破解某些加密等挑战看起来更加困难,超出了计算的范围。

为了解决P = NP问题,董庆秀和团队基于过去几年“推理”大型语言模型的趋势进行了研究。正如东京大学和谷歌研究团队在2022年的研究所示范的那样,通过在提示的开头添加短语“让我们一步一步思考”,并附上一个示例答案,可以简单地改进大型语言模型在某些任务上的能力。他们发现,这个短语足以引发语言模型的“思维链”步骤。

此外:《科学》杂志的学者表示,生成式人工智能不应被称为“艺术家”

董和他的团队追求的是苏格拉底式的思维链条。通过97个提示回合,作者们使用各种请求引导GPT-4深入探讨P = NP的数学细节,每个提示都以一个前导语来引导GPT-4的条件,例如“你是一位智慧的哲学家”、“你是一位擅长概率论的数学家”——换句话说,就是让GPT-4扮演一个角色或者“人设”,以此来给其文本生成加以风格化。

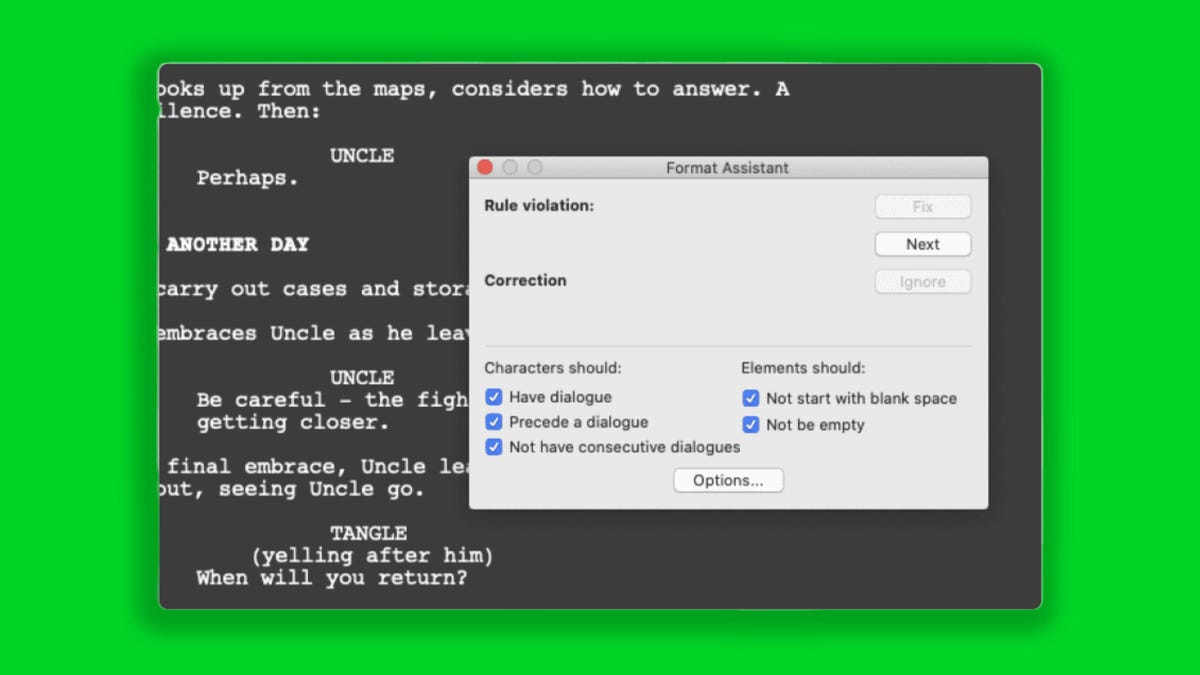

高度理论性讨论中的一个聊天回合的示例。

他们的策略是通过假设P等于NP并给出一个例子,然后找到使例子不成立的方法,从而诱导GPT-4证明P实际上并不等于NP,这种方法被称为反证法。

有趣的是,研究的两位作者Ke Xu和Guangyan Zhou分别在本月发表了一篇关于P = NP的传统数学形式的论文。在那篇论文中,他们得出结论P并不等于NP。

那么,董、徐、周和他们的团队所做的事情,就像是通过逐个提示引导GPT-4,以自己的推理语言重构形式化数学论文。事实上,在这篇73页的论文中,有67页完整地打印了97个提示和GPT-4的完整回应。就像是一个庞大的提示工程,重新构建一个论述。

至于董和他的团队用GPT-4实现的输出是否真正证明了P不等于NP,很难说,因为徐和周的论文本身很新。在汇总论文引用的Semantic Scholar网站上,除了与董和团队的论文之外,还没有其他论文引用该论文。你可以去AI网站HuggingFace上查看一些对GPT-4论文的讨论。

所以,世界还没有接受他们的论证。

对于喜欢生成式人工智能的人来说,更重要的是,作者们认为他们在提示中的对话显示了大型语言模型不仅仅能够模仿人类的文本创作,还能做更多事情。

此外:《纽约时报》和其他人对ChatGPT的误解

他们写道:“我们的研究强调了GPT-4与人类合作探索异常复杂和专业级问题的潜力。”在67页的提示和回应中,他们标注了他们认为GPT-4的“有洞察力的部分”。

这些回应有多么有洞察力,可能也是一个需要进行独立调查的话题。一些科学家发现大型语言模型在如何串联引用和描述上相当肤浅。

然而,在论文的页边空白处,董和他的团队用他们对回应的观察做了一些标注。

在其中一个括号注释中,作者在第7页的页边空白处写道,GPT-4的每个先前回应都作为最新提示的背景被纳入——除非作者选择修剪回应,只保留最相关的部分。

换句话说,董和他的团队对GPT-4在所谓的“上下文窗口”中使用过去历史的方式进行了某种有益的策划。他们通过一种非常有选择性的提示工程来引导GPT-4进行论证。这与使用过去的聊天数据作为大型语言模型的新输入的“检索增强生成”或“RAG”的实践有关。

此外:研究人员表示,ChatGPT对科学结果撒谎,需要开源替代方案

这可能是整个练习中最重要的贡献之一:无论它是否解决了P = NP问题,快速工程领域的新前沿可以使程序更接近RAG,从而使聊天会话更加深入。当你最近回想起聊天会话时,它们往往是无聊的,经常偏离主题。

通过97轮的实践,Dong和他的团队设法保持机器的焦点,这是值得肯定的。